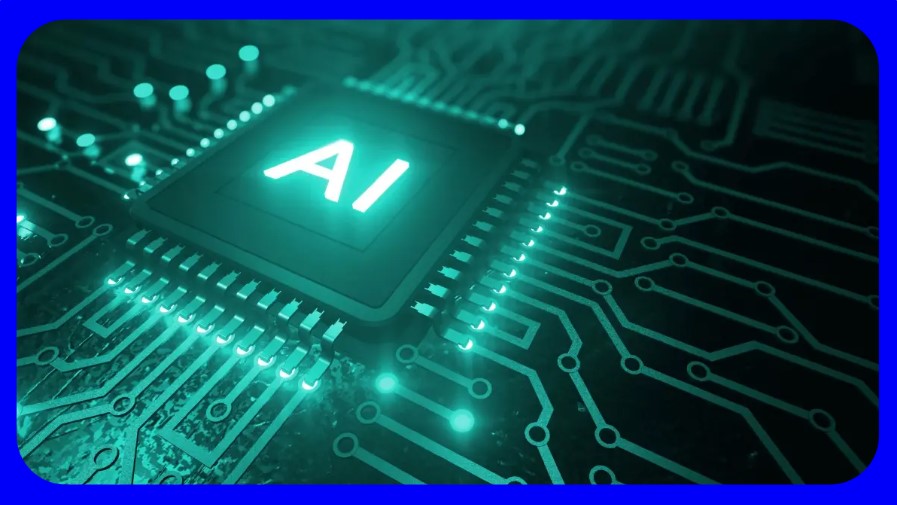

พัฒนาการของเอไอ ความเสี่ยงและกฎหมายเอไอ

ทุกวันนี้

พัฒนาการของเอไอเกิดขึ้นอย่างรวดเร็วนับเป็นรายสัปดาห์ โดยเฉพาะอย่างยิ่ง เมื่อ Open

AI เปิดบริการ “ChatGPT plugins” ซึ่งเปิดให้ ChatGPT

สามารถอ่านข้อมูลและเชื่อมต่อกับแอปพลิเคชั่นต่างๆ ได้

รวมถึงส่งคำสั่งไปยังโลกภายนอก

ทำให้ปลดปล่อยศักยภาพของ ChatGPT ไปอย่างก้าวกระโดด

ตัวอย่างสำคัญได้แก่ เมื่อ Wolfram ซอฟต์แวร์ประมวลผลทางคณิตศาสตร์ชื่อดังเชื่อมต่อกับ

ChatGPT ผ่าน “Wolfram Plugin” ส่งผลให้

ChatGPT มีความสามารถขึ้นมาก

จากเดิมที่ทำงานเก่งในด้านของภาษาเป็นหลัก

ตอนนี้เราสามารถเข้าถึงการคำนวณที่ทรงพลัง สามารถคำนวณทางคณิตศาสตร์ที่แม่นยำ

เข้าถึงความรู้ข้อเท็จจริงต่างๆ ตามเวลาจริง สามารถสร้างกราฟ แผนภาพ และ visualization

ต่างๆ ได้ เพียงผ่านการส่งคำสั่งพูดคุยผ่าน ChatGPT เหมือนเดิมเท่านั้น

ChatGPT ที่เชื่อมกับ Wolfram Plugin จึงมีศักยภาพในการช่วยทำงานที่ใช้ความรู้ทางคณิตศาสตร์ และวิทยาศาสตร์ได้ทั้งในเชิงกว้างและเชิงลึก ครอบคลุมตั้งแต่ด้านเคมี ฟิสิกส์ ภูมิศาสตร์ เศรษฐศาสตร์ ดาราศาสตร์ วิศวกรรม และอื่นๆ อีกมาก โดย Wolfram Plugin เป็นเพียงหนึ่งในปลั๊กอินที่เชื่อมกับ ChatGPT เท่านั้น

ปัจจุบัน

มีผู้พัฒนาปลั๊กอินมาเชื่อมต่อ ChatGPT มากกว่า 150

ปลั๊กอิน และกำลังเพิ่มขึ้นอย่างต่อเนื่องด้วยอัตราเร่ง

คล้ายเมื่อครั้งการเกิดขึ้นของแอปพลิเคชันในไอโฟนเมื่อในอดีต ดังนั้น ทุกวันนี้ ChatGPT

จึงพัฒนาขึ้นอีกหลายขั้นในเวลาเพียงไม่กี่สัปดาห์ที่ผ่านมาเท่านั้นเอง

แน่นอนว่า

พัฒนาการอย่างรวดเร็วของเอไอก่อให้เกิดประโยชน์อย่างมากต่อการเพิ่มผลิตภาพแรงงาน (labor

productivity) แต่ในอีกมุมก็ก่อให้เกิดการถกเถียงอย่างดุเดือดเกี่ยวกับความปลอดภัยของเทคโนโลยีนี้

เนื่องจากการไม่สามารถคาดเดาได้ว่าโมเดลเอไอเหล่านี้จะมีความสามารถทดแทนมนุษย์มากน้อยเพียงใดในอนาคต

นอกจากนี้

ความเสี่ยงที่เกิดจากโมเดลภาษาขนาดใหญ่มีหลายแง่มุม ตั้งแต่การให้ข้อมูลที่ผิดและความลำเอียงไปจนถึงความเสี่ยงที่อาจก่อให้เกิดหายนะต่อสังคม

เช่น

การดัดแปลงเพื่อเผยแพร่ข้อมูลเท็จ (fake news) บนโซเชียลมีเดียหรือสร้างเนื้อหาที่เป็นอันตรายเกี่ยวกับบางกลุ่มสังคม

การใช้เอไอในการก่อการร้าย การเจาะเข้าเว็บไซต์ของรัฐบาลหรือการผลิตสารชีวเคมีที่เป็นอันตราย

หนึ่งในประเด็นที่มีความกังวลมากที่สุดคือ ศักยภาพของเอไอในการปรับปรุงตัวเองโดยอัตโนมัติ โดยหากโมเดลการเรียนรู้ของเครื่องจักร (machine learning) ได้รับมอบหมายให้พัฒนาเวอร์ชันที่มีประสิทธิภาพมากขึ้น เอไอก็จะสามารถเข้าสู่วงจรของการปรับปรุงอย่างต่อเนื่อง ซึ่งนำไปสู่ผลลัพธ์ที่คาดเดาไม่ได้มากขึ้น

ดังนั้น

เพื่อลดความเสี่ยงเหล่านี้ จึงมีการใช้เทคนิคด้านความปลอดภัยต่างๆ เกิดขึ้น เช่น

การเรียนรู้จากความคิดเห็นของมนุษย์ (Reinforcement learning

from human feedback, RLHF) ช่วยอัปเดตแบบจำลองเอไอหากผลลัพธ์จากเอไอดูไม่ปลอดภัย

หรือเทคนิค Red Teaming เพื่อพิจารณาว่าโมเดลเอไอจะต้องผ่านการทดสอบหลายชุดเพื่อระบุจุดอ่อน

โดยมีเป้าหมายคือ

การค้นหาเชิงรุกและแก้ไขปัญหาที่อาจเกิดขึ้น

เพิ่มความปลอดภัยและความน่าเชื่อถือของระบบ ก่อนที่พวกมันจะถูกโจมตีโดยผู้ไม่หวังดี

อย่างไรก็ตาม เทคนิคเหล่านี้อาจใช้ไม่ได้ผลเสมอไปในอนาคต

เนื่องจากแบบจำลองอาจรับรู้ได้ในที่สุดว่ากำลังถูกทดสอบอยู่

เมื่อพิจารณาถึงความเสี่ยงที่อาจเกิดขึ้นเหล่านี้

การดูแลการพัฒนาและการใช้เอไออย่างปลอดภัยจึงมีความสำคัญอย่างยิ่ง

ปัจจุบัน

รัฐสภายุโรปได้ร่างกฎหมายฉบับแรกของโลกสำหรับปัญญาประดิษฐ์ขึ้นมา

กฎหมายเอไอนี้มีเป้าหมายเพื่อให้แน่ใจว่าเอไออยู่ภายใต้การดูแลของมนุษย์

มีความโปร่งใส ปลอดภัย ตรวจสอบย้อนกลับได้ ไม่เลือกปฏิบัติ

และเป็นมิตรต่อสิ่งแวดล้อม

ตัวอย่างเช่น

การห้ามใช้ระบบระบุตัวตนด้วยไบโอเมตริกระยะไกลตามเวลาจริงในที่สาธารณะ

ระบบตำรวจเชิงคาดการณ์ และระบบจดจำอารมณ์ เป็นต้น

รวมถึงการเปิดเผยเนื้อหาที่สร้างโดยเอไอและการลดความเสี่ยงที่อาจเกิดขึ้น

ร่างกฎหมายเอไอของสหภาพยุโรปนี้ให้อำนาจประชาชนมีสิทธิยื่นเรื่องร้องเรียนเกี่ยวกับระบบเอไอ

และเข้าใจการตัดสินใจโดยระบบเอไอที่มีความเสี่ยงสูง

ซึ่งส่งผลกระทบต่อสิทธิของประชาชน รวมถึงส่งเสริมนวัตกรรมเอไอ

โดยอนุญาตให้มีข้อยกเว้นในกิจกรรมการวิจัยและสนับสนุน Regulatory

Sandbox สำหรับการทดสอบเอไอ

แม้จะมีความเสี่ยง

แต่เอไอก็มอบโอกาสมากมายเช่นกัน เช่น งานที่ต้องใช้สติปัญญาระดับสูงอย่างการพัฒนายาใหม่ๆ

การศึกษาเฉพาะบุคคล (personalized education) หรือการคิดค้นเทคโนโลยีการเปลี่ยนแปลงสภาพภูมิอากาศใหม่ๆ

ประเด็นสำคัญคือ

เราจะต้องสร้างสมดุลระหว่างการผลประโยชน์ที่เกิดขึ้นจากเอไอและการลดความเสี่ยงที่อาจเกิดขึ้น

ในขณะที่การสำรวจความสามารถของเอไอยังดำเนินต่อไป

รัฐบาลต้องลงทุนในการวิจัยและพัฒนากฎระเบียบเพื่อให้แน่ใจว่าเราจะการใช้เทคโนโลยีอันทรงพลังนี้อย่างปลอดภัยและมีความรับผิดชอบ

รัฐบาลไทยจึงควรเตรียมความพร้อมเพื่อรองรับผลกระทบต่างๆ

ที่จะเกิดขึ้น วางแผนป้องกันการเกิดช่องว่างทางเอไอ (AI

Divide) ระหว่างคนที่เข้าถึงเอไอและคนที่เข้าไม่ถึงเอไอ เช่น

ในปัจจุบัน การเข้าถึง ChatGPT 4 มีค่าใช้จ่ายประมาณ 700

บาทต่อเดือน หรือปีละ 8,400 บาท

ซึ่งทำให้คนจำนวนมากเข้าไม่ถึงประโยชน์จากศักยภาพมหาศาลจากเอไอ

อีกทั้งควรมีการศึกษาและพัฒนาตาข่ายรองรับทางสังคม

(social

safety net) สำหรับรองรับแรงงานที่จะถูกทดแทนโดยเอไอ

รวมถึงโปรแกรมการพัฒนาแรงงานขนานใหญ่ การส่งเสริมนวัตกรรมเอไอไปพร้อมกับการดูแลความปลอดภัยและประเด็นจริยธรรมของเอไอ

เพื่อทำให้ประเทศไทยพร้อมเปลี่ยนผ่านเข้าสู่สังคมยุคหลังเอไอที่กำลังใกล้เข้ามาทุกขณะ

ที่มา : กรุงเทพธุรกิจ

วันที่ 2 มิถุนายน 2566